Chat with RTX ya disponible, IA en local gracias a la potencia de GeForce RTX

La IA ha dejado de ser el futuro para convertirse en el presente, en una realidad que nos hace la vida mucho más fácil, y que gracias a Chat with RTX ya podemos aprovechar en local. Sí, has leído bien, esta solución trabaja de forma local, lo que se traduce en una seguridad y una privacidad total, y encima está tan bien optimizada que funciona sin problemas con GPUs GeForce RTX 30 y 40, tanto de sobremesa como de portátil.

Qué es Chat with RTX

Es una demo técnica totalmente gratuita que ya está disponible para descarga que integra un chatbot personalizable. Puede trabajar con Llama2 13B INT4 y también con Mistral 7B INT4, es decir, con dos de los modelos de lenguaje de inteligencia artificial más populares del momento. El primero utiliza 13.000 millones de parámetros, y el segundo 7.000 millones de parámetros (recordad que un billón anglosajón equivale a 1.000 millones europeos).

Chat with RTX utiliza generación aumentada de recuperación (RAG), una técnica que permite mejorar la precisión y fiabilidad de los modelos generativos de IA con datos obtenidos de fuentes externas. También se ha utilizado el software NVIDIA TensorRT-LLM, una una biblioteca fácil de integrar que es capaz de aprovechar de forma óptima la capacidad de cómputo en tareas relacionadas con IA de los núcleos Tensor que incluyen las tarjetas gráficas GeForce RTX, y que puede multiplicar por cuatro el rendimiento.

Qué necesito para poder utilizarlo

- Tarjeta gráfica GeForce RTX serie 30 o serie 40 con al menos 8 GB de memoria gráfica.

- 100 GB de espacio libre. Puede variar en función de los modelos de lenguaje que instalemos.

- Windows 10 o Windows 11 como sistema operativo.

- Drivers de la tarjeta gráfica actualizados a la última versión disponible.

Cómo funciona Chat with RTX

El proceso es muy sencillo, y creo que este es precisamente uno de los grandes valores que ofrece esta demo técnica, que acerca la IA bajo el modelo chatbot (robot conversacional) incluso a los usuarios con menos experiencia, adoptando un proceso de instalación y de configuración automatizados, y una interfaz simple e intuitiva.

Solo tenemos que descargarlo siguiendo este enlace e iniciar el proceso de instalación, que como he dicho se realizará de forma automatizada. Una vez que finalice nos aparecerá el icono de acceso directo en el escritorio, y haciendo doble clic en él se abrirá una consola de comandos que nos llevará automáticamente a una pestaña del navegador que tengamos como predeterminado. Ahí podremos empezar a disfrutarlo.

La interfaz es muy simple, tenemos una sección en la parte inferior donde podemos escribir cualquier pregunta o elegir entre las sugerencias que nos da el modelo personalizado con la base de datos preinstalada. También podemos cambiar con un simple clic entre los modelos de IA disponibles, Llama2 si utilizamos un PC muy potente o Mistral si tenemos una configuración más modesta.

En la parte de la esquina superior derecha podemos elegir la fuente que «alimentará» al modelo de IA. Dicha fuente puede ser la base de datos preinstalada con Chat with RTX, y también podemos cambiar a nuestro propio conjunto de archivos tipo .txt, .PDF y .doc, o incluso utilizar enlaces a vídeos y listas de reproducción de YouTube.

Mi primer contacto con Chat with RTX

Quise dedicar unas horas a probar esta demo técnica en dos equipos muy distintos para ofreceros una visión realista de lo que podéis esperar de ella, tanto con una configuración de hardware muy potente como con una más modesta y asequible para el consumidor medio. En mi PC personal, equipado con un Ryzen 7 7800X3D, 64 GB de RAM y una GeForce RTX 4090 con 24 GB de memoria gráfica pude utilizar sin problemas el modelo Llama2 13B, y la experiencia fue fantástica.

El tiempo de inicio con ese equipo es de apenas unos segundos, podemos escribir preguntas en español o en inglés de forma totalmente natural, incluso simplificarlas o complicarlas al máximo, y los tiempos de respuesta son prácticamente instantáneos. La precisión de las respuestas es excelente con todas las fuentes de alimentación disponibles, y para muestra un botón.

Cuando utilicé un enlace a un vídeo de Diablo 2 Resurrected donde se recoge la construcción de un «Tesladin», una versión del Paladin, Chat with RTX fue capaz de explicarme qué equipamiento debía utilizar para crear esa build según el vídeo. Sí, es impresionante, y el tiempo que necesitó para realizar previamente la transcripción del vídeo fue de apenas unos segundos. Su potencial está fuera de toda duda, el rendimiento es excelente y bajo Llama2 13B es capaz incluso de seguir la conversación por contexto y referencias a preguntas anteriores.

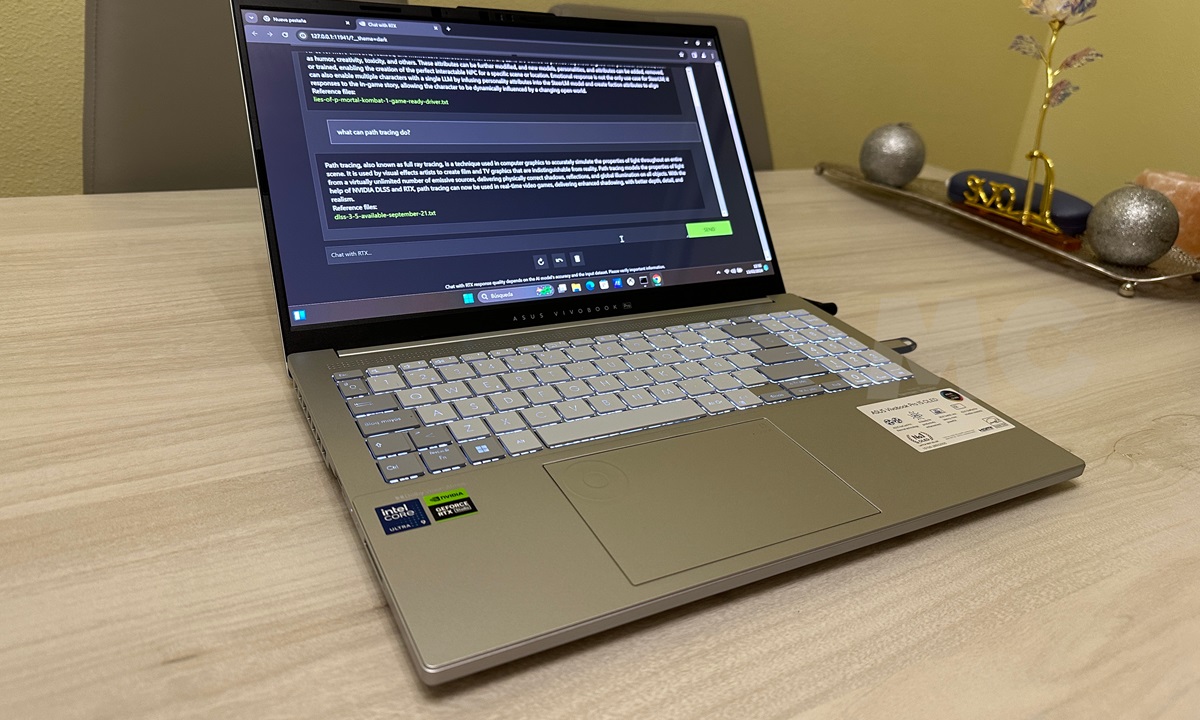

El segundo equipo que utilicé para probar Chat with RTX fue un ASUS Vivobook Pro con Intel Core Ultra 9-185H, 16 GB de RAM y tarjeta gráfica GeForce RTTX 4060 Mobile con 8 GB de memoria gráfica. En este caso estuve limitado a Mistral 7B, pero el rendimiento también fue excelente y la experiencia de uso se mantuvo a un nivel sobresaliente. NVIDIA ha hecho un excelente trabajo con esta solución, que ofrece un valor muy interesante tanto a particulares como a profesionales.