NVIDIA da el impulso definitivo a la IA en cliente

El rol que está jugando NVIDIA en la evolución de la inteligencia artificial es difícilmente mesurable. A este respecto, el foco se suele situar en las soluciones dirigidas específicamente a centros de cómputo y a sistemas de ultra alto rendimiento, empleados con fines de lo más diversos: desde el funcionamiento de un chatbot hasta complejos modelos de estimación de todo tipo de valores. En el entorno profesional, y aunque otros fabricantes quieren diseñar sus propios integrados, NVIDIA reina a día de hoy holgadamente.

Sin embargo, en nuestro caso nos interesa más lo que es capaz de hacer el gigante verde a la hora de acercar la inteligencia artificial al usuario final (para las soluciones profesionales, tenemos a nuestros compis de MuyComputerPRO), y es que aunque la mayoría de servicios basados en IA que empleamos de manera habitual, cada vez hay más operaciones que se pueden llevar a cabo de manera local, gracias a la capacidad de cómputo especializada en IA que ofrecen componentes como los procesadores Intel Meteor Lake y las tarjetas gráficas NVIDIA GeForce RTX. El ejemplo más evidente lo encontramos en funciones como DLSS y en aplicaciones como Broadcast, pero la lista no para de crecer.

Hace unos meses, durante la Microsoft Build, Microsoft y NVIDIA anunciaron una ambiciosa colaboración para llevar la computación de IA al cliente y hoy nos encontramos con un importantísimo avance en este sentido, que ha sido anunciado en Microsoft Ignite, otro evento clave en el calendario de los de Redmond, un avance que promete multiplicar hasta por cuatro el rendimiento del hardware ya existente en la actualidad a la hora de trabajar con modelos de lenguaje extensos (LLMs).

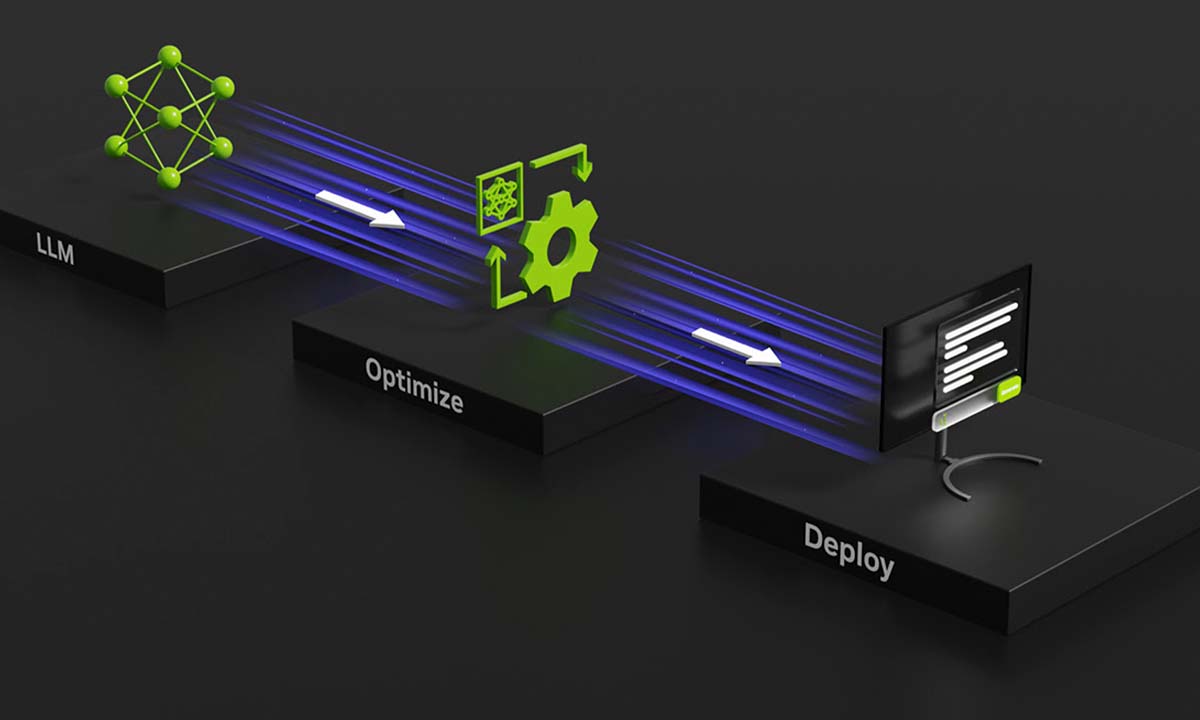

En el gráfico superior puedes comprobar la cantidad de tokens por segundo que puede generar un sistema que integra una GPU RTX 4060 y una RTX 4090 al emplear un LLM como Llama 2, del Meta. Este salto en rendimiento llega de la mano de la nueva versión de TensorRT-LLM, la biblioteca de la que ya te hablamos hace unas semanas, y que tras ser anunciada inicialmente para centros de cómputo, empezó a dar al salto Windows, fruto de la colaboración entre Microsoft y NVIDIA, donde jugará un papel clave en el despliegue de la IA en local.

Así, en el contexto de Microsoft Ignite, además de mostrarnos unos datos de rendimiento tan sorprendentes, NVIDIA ha hecho los siguientes anuncios:

- La nueva versión de TensorRT-LLM admite LLM adicionales que pueden ejecutarse en cualquier GPU GeForce RTX serie 30 y serie 40 con 8 GB de RAM o más, incluso en ordenadores portátiles.

- TensorRT-LLM también será compatible con la API de ChatGPT, lo que permitirá ejecutar cientos de proyectos y aplicaciones para desarrolladores utilizando TensorRT-LLM en RTX.

- NVIDIA y Microsoft están lanzando mejoras de DirectML para acelerar Llama 2 y Stable Diffusion para brindar a los desarrolladores más opciones para la implementación entre proveedores.

Obviamente, al ver el gráfico superior, vemos que la GPU tope de gama de NVIDIA promete ofrecer un rendimiento espectacular, pero si hay algo que me ha sorprendido, y para muy bien, es que TensorRT-LLM permitirá el uso de soluciones basadas en un LLM no solo en la actual generación de GeForce RTX, sino también en la anterior. Esto, claro, incentiva a que los desarrolladores de juegos y de aplicaciones, decidan emplear TensorRT-LLM en sus desarrollos, pues el parque combinado de usuarios de adaptadores gráficos RTX 30 y RTX 40 de escritorio y de las versiones Mobile es, sin duda, un mercado tremendamente amplio, que se puede beneficiar mucho de esta tecnología.