A Fondo

Así han evolucionado las tarjetas gráficas en los últimos 15 años

La evolución que ha vivido el sector de las tarjetas gráficas en los últimos 15 años ha sido verdaderamente enorme, y no solo en términos cuantitativos, sino también a nivel cualitativo. Cada salto generacional ha introducido mejoras de rendimiento importantes y ha traído incrementos en cosas tan importantes como la cantidad de memoria gráfica disponible, pero también nos ha dejado cambios a nivel de arquitectura que al final nos han permitido avanzar de una manera mucho más marcada, y más interesante.

En este artículo vamos a echar la vista al pasado para dar un interesante paseo por esos 15 años de evolución que ha vivido el sector de las tarjetas gráficas. Sé lo que estáis pensando, ¿por qué solo esos últimos 15 años? La respuesta es muy sencilla, porque este artículo es un especial con el que queremos celebrar con vosotros el décimo quinto cumpleaños de TPNET, es decir, el 15 cumpleaños de MuyComputer. Sí, ya llevamos quince años con vosotros, qué rápido pasa el tiempo, ¿verdad?

El punto de partida de este artículo serán aquellas tarjetas gráficas que llegaron al mercado a partir de 2008, y seguiremos su evolución hasta el primer trimestre de 2023, aunque miraremos un poco a años anteriores para entender mejor lo sucedido en 2008, un año que sin duda fue clave para el sector. De no hacerlo perderíamos un contexto muy valioso que necesitamos para que el artículo sea más fácil de

Durante ese largo recorrido veremos las claves más importantes que definieron a las generaciones gráficas más relevantes de NVIDIA, de la extinta ATi y de AMD en cada momento, y os contaremos todo lo que debéis saber sobre ellas. Estoy convencido de que estáis deseando acompañarnos en este viaje en el tiempo, así que no os hago esperar más, abrochaos los cinturones que empezamos.

Evolución de las tarjetas gráficas

Llegada de la arquitectura de shaders unificados, «hot shaders» y superación de la barrera del gigabyte de memoria gráfica

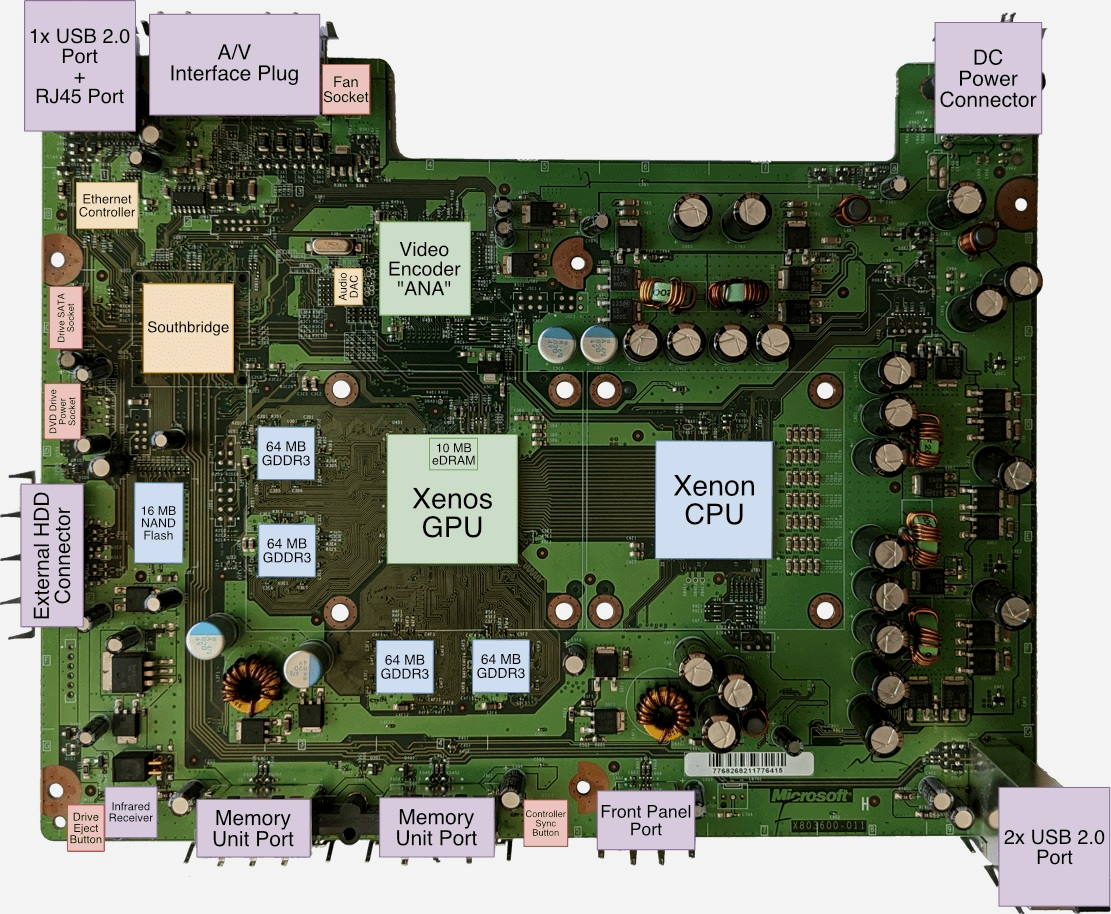

La llegada de las GeForce 7000 tuvo una importante repercusión en el sector de las tarjetas gráficas, no tanto por la evolución que supusieron en términos de rendimiento, sino más bien porque fue la generación elegida por Sony para dar vida a la GPU de PS3. Microsoft, por contra, tomó una decisión más inteligente y montón una GPU ATi que era mucho más avanzada, ya que utilizaba una arquitectura de shaders unificados.

Xbox 360 fue una adelantada a su tiempo precisamente por eso, porque llegó en 2005 y su GPU utilizaba una arquitectura que todavía no se había lanzado al mundo del PC. Los shaders unificados llegaron a las tarjetas gráficas para PC a principios de 2007 con las Radeon HD 2900 XT de ATi, y posteriormente NVIDIA dio el salto también a esta arquitectura con las GeForce 8000. Si os interesa este tema, tenéis más información en nuestro especial dedicado a equivalencias gráficas de las consolas.

Este cambio de arquitectura tuvo implicaciones muy profundas, puesto que eliminó la división entre pixel y vertex shaders y sentó las bases de la arquitectura que todavía utilizamos a día de hoy. La mejora que supuso en términos de rendimiento fue enorme, tanto que una GeForce 8800 GT llegaba a duplicar el rendimiento de una GeForce 7900 GT, aunque ATi tuvo un debut más accidentado que NVIDIA, y su serie HD 2000 quedó bastante por debajo de las GeForce 8000 en términos de rendimiento.

En 2008 se produjo la consagración de la arquitectura de shaders unificados con la llegada de las GeForce 9000 y las Radeon HD 3000. ATi logró mejorar sustancialmente el rendimiento con estas nuevas tarjetas gráficas, y dio forma a una generación muy competitiva, sobre todo en relación precio-rendimiento. Dentro de esta generación llegaron algunas de las tarjetas gráficas con mejor relación precio-prestaciones de toda la historia, como las GeForce 9600 GT y la Radeon HD 3870.

Con la arquitectura de shaders unificados se produjo también la introducción de las primeras configuraciones con 1 GB de memoria gráfica, y en NVIDIA apostaron por los «hot shaders», una tecnología que hacía que los shaders funcionaran a una velocidad mucho mayor que el resto de la GPU. Por ejemplo, la GeForce 8800 GT tenía una frecuencia de 600 MHz en la GPU y de 1.500 MHz a nivel de shaders.

En los años venideros tanto NVIDIA como ATi mantuvieron la base de los shaders unificados, y las mejoras de rendimiento más importantes que se fueron produciendo se debieron principalmente a un aumento de la cantidad total de estos, algo que obviamente estuvo acompañado de un incremento del ancho de banda para evitar cuellos de botella. Esto fue especialmente notable en modelos como la GeForce GTX 285, que contó con 240 shaders y un ancho de banda de 159 GB/s, mientras que la GeForce 8800 GTX tenía 128 shaders y un ancho de banda de 86,40 GB/s.

Por el lado de ATi destacó especialmente la Radeon HD 4890, una tarjeta gráfica muy potente que contaba con 800 shaders y tenía un ancho de banda de 124,8 GB/s. A efectos comparativos, la Radeon HD 3870 solo tenía 320 shaders y un ancho de banda de 72,06 GB/s. Recordad que ATi tenía que montar una mayor cantidad de shaders comparada con NVIDIA porque esta no utilizaba los «hot shaders», es decir, GPU y shaders funcionaban a la misma frecuencia.

Las Radeon HD 5000 y las GeForce GTX 400 fueron las primeras en contar con soporte de DirectX 11, pero al final mantuvieron la misma tónica de generaciones anteriores, más shaders y más ancho de banda para aumentar la potencia bruta. Las Radeon HD 6000 y GeForce GTX 500 fueron una evolución menor de las anteriores, aunque bastante meritorias en algunos aspectos, ya que dispararon el conteo de shaders y en el caso de la GeForce GTX 580 en NVIDIA alcanzaron por primera vez los 3 GB de memoria gráfica (fue una edición muy limitada).

Para que os hagáis una idea más clara, la GeForce GTX 580 contaba con 512 shaders y tenía un ancho de banda de 192,4 GB/s, mientras que la Radeon HD 6970 tenía 1.536 shaders y un ancho de banda de 176 GB/s. Fueron las dos tarjetas gráficas más potentes de NVIDIA y AMD, que en aquel momento ya había suprimido la marca ATi, lanzadas entre 2010 y 2011, y fueron también las últimas antes del gran cambio que estaba por venir, y que os vamos a contar a continuación.

Fin de los «hot shaders», computación asíncrona y auge de la memoria gráfica

La primera en mover ficha dentro de esta nueva etapa fue AMD, quien lanzó las Radeon HD 7950 y HD 7970. Estas tarjetas gráficas utilizaban una nueva arquitectura conocida como GCN 1.0, que habría sido desarrollada pensando en DirectX 12 y en las nuevas características que introducía dicha API, entre las que podemos destacar sin duda la computación asíncrona.

Fue una adelantada a su tiempo, y esto le dio problemas, porque en aquel entonces DirectX 11 dominaba el gaming en PC, y la nueva arquitectura de NVIDIA rendía mejor con dicha API. AMD también acertó la incluir, por defecto, una mayor cantidad de memoria gráfica en estas tarjetas gráficas, y es que mientras que NVIDIA solo ofrecía configuraciones con 2 GB en la gama alta su equivalente ya contaba con 3 GB de memoria gráfica.

Estoy hablando de Kepler, una arquitectura que también supuso un cambio importante para NVIDIA, ya que marcó el fin de los «hot shaders», y esto obligó a los de verde a disparar la cantidad de shaders para poder aumentar el rendimiento La GeForce GTX 680, sucesora de la GeForce GTX 580, tenía 1.536 shaders, el triple que aquella que solo contaba con 512 shaders, pero estos funcionaban a un máximo de 1.058 MHz, mientras que en la generación anterior se movían a 1.544 MHz.

Sony y Microsoft eligieron la arquitectura GCN de AMD para sus consolas PS4 y Xbox One, y esta se acabó convirtiendo en el gran estandarte de AMD para los próximos años. Tanto es así que tuvimos que esperar a la llegada de la arquitectura RDNA para ver a una auténtica sucesora de aquella, y su lanzamiento no se produjo hasta finales de 2019. Sí, AMD tuvo que apurar mucho el uso de GCN, de hecho esta arquitectura tuvo hasta cinco revisiones distintas, y estas se utilizaron en PS4 Pro y Xbox One X.

AMD fue aumentando el número de shaders y las frecuencias de trabajo para aumentar el rendimiento de sus nuevas generaciones, y también utilizó diferentes configuraciones de memoria gráfica, llegando a recurrir en ocasiones a la carísima, aunque rapidísima, memoria HBM. A efectos comparativos, la Radeon HD 7970, lanzada a finales de 2011 y basada en GCN 1.0, tenía 2.048 shaders a 925 MHz, 3 GB de memoria gráfica y un ancho de banda de 264 GB/s, mientras que la Radeon RX Vega 64, basada en GCN 5.0 y lanzada en 2017, tenía 4.096 shaders, 8 GB de memoria HBM2 y un ancho de banda de 483,8 GB/s.

En el caso de NVIDIA, el soporte de DirectX 12 fue bastante pobre en las GeForce GTX 600 y GTX 700, ambas basadas en la arquitectura Kepler (con excepción de las GTX 750 y GTX 750 Ti, que utilizaban la arquitectura Maxwell de primera generación). Sin embargo, esto fue un problema ni a corto ni a medio plazo porque, como he dicho, DirectX 11 dominó el sector durante muchos años. Con la GTX 780 Ti, lanzada en 2013, en NVIDIA dieron un salto enorme en términos de potencia bruta al montar 2.880 shaders, casi el doble de los que tenía una GeForce GTX 680, y fue un auténtico monstruo capaz de mover juegos en 4K.

La cosa mejoró mucho con Maxwell, una arquitectura que supuso un salto muy grande frente a Kepler, tanto que una GeForce GTX 970 con solo 1.664 shaders era capaz de superar en rendimiento a la GeForce GTX 780 Ti. Contaba, además, con más memoria gráfica (4 GB frente a 3 GB), era mucho más eficiente y se llevaba mejor con DirectX 12. Esa GeForce GTX 970 fue, precisamente, una de las mejores tarjetas gráficas que ha lanzado NVIDIA en toda su historia, tanto que todavía hoy es capaz de mover juegos actuales en 1080p de forma decente, y eso que llegó al mercado en 2014.

No obstante, tuvimos que esperar a Pascal, la arquitectura de las GeForce GTX 10, para que NVIDIA realmente abrazase de plano DirectX 12 y Vulkan. La GeForce GTX 1070 dobló la memoria gráfica de su antecesora (de 4 GB pasó a 8 GB), y a pesar de su configuración con 1.920 shaders fue capaz de superar a la GeForce GTX 980 Ti, que tenía 2.816 shaders. AMD no le puso la cosa nada fácil, ya que sus Radeon RX Vega 56 y Radeon RX Vega 64 ofrecían un rendimiento muy bueno frente a las GeForce GTX 1070 y GTX 1080, pero la GeForce GTX 1080 Ti fue un auténtico monstruo, tanto que ni siquiera la Radeon VII pudo superarla.

A día de hoy, la GeForce GTX 1080 Ti sigue siendo tan potente que todavía es capaz de mover juegos en resolución 4K, aunque es cierto que en términos de arquitectura ha sido ampliamente superada. En este sentido, AMD solo logró poner en el mercado algo realmente competitivo cuando lanzó la Radeon RX 5700 XT, una tarjeta gráfica que fue la gran abanderada de la arquitectura RDNA, y que sentó las bases del próximo gran salto de la compañía de Sunnyvale.

En líneas generales la arquitectura RDNA de primera generación introdujo cambios importantes, de hecho fue la primera en utilizar lo que hoy conocemos como WGP o «grupo de procesadores de trabajo», que están formados por dos unidades de computación. También permitió una enorme subida de las frecuencias de trabajo (casi 2 GHz), que fue en gran medida la responsable del incremento de rendimiento, y sin descuidar el consumo y la eficiencia.

Núcleos especializados, trazado de rayos, inteligencia artificial y diseños multi-chiplet

A pesar de todos los cambios que se produjeron en la etapa anterior podemos decir que, en general, se mantuvo la misma base que introdujeron hace años los shaders unificados, porque al final las cargas de trabajo y los juegos se afrontaban partiendo de la misma base. Esta realidad no empezó a cambiar hasta finales de 2018, cuando NVIDIA introdujo la arquitectura Turing con las GeForce RTX 20. Dicha arquitectura parte de la misma base que encontramos en una GPU tradicional, pero añade dos grupos de núcleos especializados:

- Núcleos RT: que están especializados en operaciones asociadas al trazado de rayos.

- Núcleos tensor: que están especializados en operaciones asociadas a la inferencia, el aprendizaje profundo y la inteligencia artificial.

A partir de ese momento, una GPU ya no se limitaba a los bloques de shaders, texturizado, geometría y rasterizado, sino que pasaba a contar con esos nuevos núcleos que abrían las puertas al uso de nuevas tecnologías, y a la creación y aplicación de efectos que anteriormente eran imposibles porque tenían un coste prohibitivo en términos de rendimiento, como el trazado de rayos.

Esa especialización que introdujo Turing ha sido la que ha permitido el último gran salto en el sector de las tarjetas gráficas, y en líneas generales creo que es incluso mayor que el que se produjo cuando el T&L (transformación e iluminación) pasó de calcularse en la CPU y se empezó a realizar en la GPU (esto ocurrió con la llegada de la GeForce 256).

Recuerdo que, cuando NVIDIA llevó a cabo esta apuesta por la especialización, le llovieron innumerables críticas, pero al final AMD acabó siguiendo sus pasos con la arquitectura RDNA2, que fue la primera de la compañía en introducir unidades de aceleración para trazado de rayos. Con esta arquitectura AMD logró un salto importante en términos de rendimiento en rasterización, gracias a tres grandes claves:

- Dobló los shaders frente a la generación anterior, llegando a los 5.120 shaders (Radeon RX 6900 XT).

- Estandarizó los 16 GB de memoria gráfica en la gama alta.

- Aumentó mucho las frecuencias de trabajo.

- Introdujo un enorme bloque de caché L3 que permitía generar un pico de ancho de banda importante, y reducir la dependencia de la GPU del ancho de banda de la memoria gráfica.

Poco a poco se fue aplicando el trazado de rayos a juegos, aunque de una manera limitada porque incluso con hardware dedicado su impacto en el rendimiento era enorme. Como respuesta, NVIDIA introdujo el DLSS, una tecnología de reescalado y reconstrucción inteligente de la imagen que fue un fracaso en su primera versión, pero que acabó triunfando en su segunda versión, y que a día de hoy se ha convertido en uno de los referentes de la industria, y en uno de los principales valores de las tarjetas gráficas de NVIDIA.

Los de verde jugaron muy bien sus cartas en este sentido, y supieron aprovechar la IA, y los núcleos tensor, para crear una tecnología que puede llegar a triplicar el rendimiento en juegos sin que el usuario tenga que hacer grandes sacrificios en calidad de imagen. También fue muy criticada, pero al final AMD acabó adoptando una estrategia similar con las tecnologías FSR y FSR 2, que realizan también un reescalado de la imagen, pero no llegan al nivel del DLSS 2 porque no utilizan inteligencia artificial.

Con las GeForce RTX 30, basadas en la arquitectura Ampere, NVIDIA dio un salto enorme en términos de potencia bruta, gracias al incremento del número total de shaders por unidad SM. Esto hizo que, por ejemplo, la GeForce RTX 3060 tuviera 3.584 shaders, mientras que la GeForce RTX 2060 solo tenía 1.920 shaders. También mejoró la potencia de los núcleos RTX y núcleos tensor, y subió en gran medida las frecuencias de trabajo.

No obstante, y sin desmerecer a Ampere, la verdad es que la arquitectura Ada Lovelace, utilizada en las GeForce RTX 40, también ha sido un salto muy interesante, y en todos los sentidos. En términos de eficiencia representa una evolución enorme, tanto que una GeForce RTX 4060 de 110 vatios puede rendir un 20% más que una GeForce RTX 3060 consumiendo 170 vatios.

En rendimiento, vemos que la GeForce RTX 4090 es capaz de superar a la GeForce RTX 3090 en un 40% bajo rasterización, y los avances que ha introducido a en trazado de rayos e inteligencia artificial confirman que se trata de la arquitectura más avanzada que existe actualmente, tanto que es la única capaz de mover con fluidez el modo Overdrive de Cyberpunk 2077, que utiliza path tracing.

También hay que destacar el papel del DLSS 3, que es exclusivo de las GeForce RTX 40, y que permite generar un fotograma totalmente en la GPU por cada dos fotogramas renderizados de forma tradicional. Esto responde a una necesidad fundamental viendo los pobres desarrollos que llegan al mundo del PC, reducir el impacto del cuello de botella producido por la CPU y mejorar la experiencia sin seguir reduciendo la resolución base de renderizado.

AMD, por su parte, nos sorprendió con la arquitectura RDNA3, que mantiene a grandes rasgos la base de la arquitectura RDNA2, pero introduce mejoras a nivel de eficiencia y de rendimiento bruto, y trae también cambios importantes a nivel interno, como la introducción de los núcleos de segunda generación para acelerar trazado de rayos, que mejoran enormemente el rendimiento frente a los de primera generación, y también la integración de nuevos núcleos especializados en IA, aunque estos de momento no se han aprovechado de una manera concreta.

La arquitectura RDNA3 también ha sido la primera en utilizar un diseño multi-chiplet, aunque lo ha hecho de una forma curiosa, porque la GPU sigue teniendo un diseño de núcleo monolítico, y lo que se ha externalizado en chiplets ha sido la caché L3. Una jugada muy inteligente por parte de AMD, ya que le ha permitido llevar a la oblea una GPU muy potente reduciendo el espacio ocupado a nivel de silicio al externalizar la caché L3. Esto también minimiza la complejidad a nivel de oblea, aumenta la tasa de éxito y reduce los costes.

Llegados a este punto puede que te preguntes qué es lo que nos depara el futuro. No tengo una bola de cristal para verlo, pero en líneas generales creo que se mantendrá la tendencia actual durante unos cuantos años, es decir, esa división entre GPU tradicional y núcleos especializados en trazado de rayos e IA, y que la inteligencia artificial será cada vez más importante para mejorar el rendimiento en juegos sin tener que tirar de potencia bruta.

En cuanto al diseño de las GPUs, es solo cuestión de tiempo hasta que nos acabemos encontrando con un diseño MCM, es decir, con una súper GPU formada por dos o más GPUs de menor tamaño que estarán interconectadas. Tarde o temprano tanto NVIDIA como AMD tendrán que seguir este camino porque, al final, el espacio a nivel de silicio es limitado, y embutir en un único chip una enorme cantidad de componentes para crear una GPU con decenas de miles de shaders no será viable, ni a nivel técnico ni a nivel de costes.

-

GuíasHace 6 días

GuíasHace 6 díasQué placa base elegir: Guía de compras para Intel y AMD

-

GuíasHace 2 días

GuíasHace 2 díasGuía para diferenciar generaciones y gamas de tarjetas gráficas

-

A FondoHace 6 días

A FondoHace 6 díasOfertas Flash del Black Friday 2024 de PcComponentes

-

A FondoHace 4 días

A FondoHace 4 díasGeForce RTX 5050, especificaciones, rendimiento, equivalencias, fecha de lanzamiento y posible precio