A Fondo

GeForce RTX serie 40: Posibles especificaciones, rendimiento estimado y precio

NVIDIA sigue trabajando en sus GeForce RTX serie 40, su próxima generación de tarjetas gráficas para el mercado de consumo general. Hace poco os contamos que su lanzamiento podría producirse en septiembre de este año, y también hablamos por encima de sus posibles especificaciones, de los primeros modelos que llegarían al mercado y del papel que podría jugar la arquitectura Hopper.

Como ya sabéis los que nos leéis a diario, las GeForce RTX serie 40 estarán basadas en la arquitectura Ada Lovelace, mientras que la arquitectura Hopper será, en teoría, una arquitectura exclusiva para el sector profesional. No obstante, os recuerdo que también circulan informaciones que aseguran que Hopper podría ser la arquitectura utilizada en las GeForce RTX serie 50. Ahora mismo no hay nada oficial, así que ambas opciones están abiertas.

Gracias a una reciente ronda de filtraciones hemos podido descubrir también que Blackwell es el nombre de la arquitectura que llegará después de Hopper, aunque no tenemos detalles a nivel técnico de ninguna de estas dos generaciones, más allá de lo que ya os hemos contado sobre esta última, su posible diseño MCM (módulo multi chip) que permitirá a NVIDIA crear una súper GPU combinando GPUs más pequeñas.

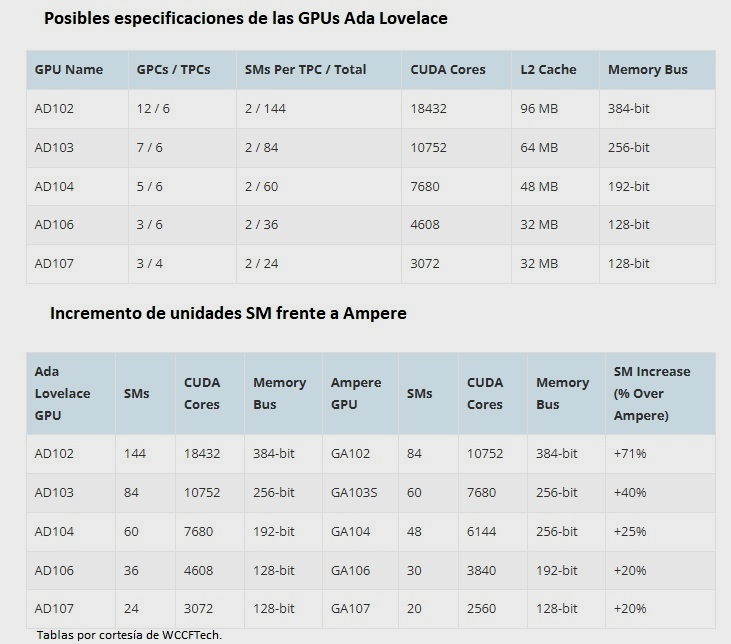

El caso es que, además de esa filtración relacionada con Blackwell, se ha producido otra que nos ha dejado ver las que serán, en teoría, las especificaciones de todas las GPUs que NVIDIA utilizará para crear las GeForce RTX serie 40. Es importante que tengáis en cuenta, antes de entrar a ver dichas especificaciones, que estas representan los valores máximos que tendría cada GPU en su configuración completa, y que NVIDIA podría utilizar versiones recortadas en diferentes tarjetas gráficas dentro de la serie RTX 40.

Por si alguno no entiende lo que acabo de decir os lo explico con un ejemplo aplicado a la generación actual. El núcleo gráfico GA102, que se utiliza en tarjetas gráficas como las RTX 3080, RTX 3080 Ti y RTX 3090 está formado por 84 unidades SM que equivalen a un total de 10.752 shaders. Sin embargo, la versión utilizada en la RTX 3080 solo tiene activos 8.704 shaders, mientras que las variantes integradas en las otras dos tarjetas gráficas suman 10.240 shaders y 10.496 shaders. Solo la RTX A6000 utiliza el núcleo completo con sus 10.752 shaders activos.

GeForce RTX serie 40: NVIDIA utilizará cinco GPUs distintas

Y encuadradas en gamas diferentes, como cabía esperar, aunque la nomenclatura no distará de lo que hemos visto en la generación actual. También es probable que al menos dos de las GPUs que vamos a ver se utilicen únicamente en las GeForce RTX serie 40 Mobile, es decir, en las versiones para portátiles, algo que ya ha ocurrido con el núcleo GA107, por ejemplo, que se ha limitado a las GeForce RTX 3050 y 3050 Ti Mobile. Si tuviera que apostar, diría que los AD103 y AD107 serán GPUs exclusivas para portátiles.

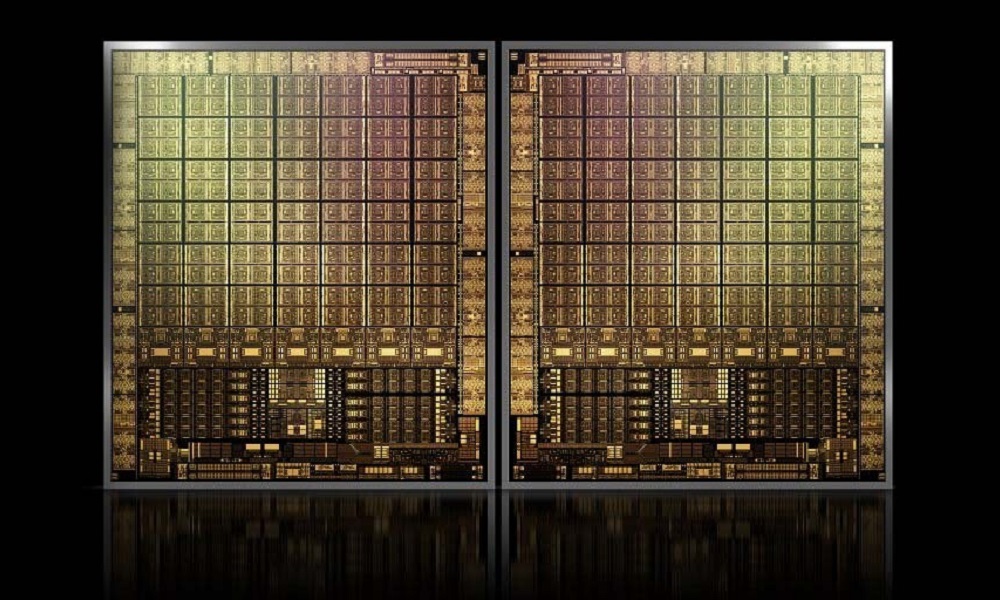

Toda las GPUs que darán vida a las GeForce RTX serie 40 utilizarán, como hemos dicho, un diseño de núcleo monolítico, lo que significa que todos los elementos clave de la GPU estarán integrados en una única pastilla de silicio. También se espera que estén fabricadas en el nodo de 5 nm de TSMC, lo que supone un salto notable frente al proceso de 8 nm de Samsung que utilizan actualmente las GeForce RTX serie 30, y que vengan con memoria GDDR6X más rápida.

Las últimas informaciones también sugieren que NVIDIA habría decidido aumentar enormemente la cantidad de caché L2 en las GeForce RTX serie 40, un movimiento que algunos han comparado a lo que hizo AMD con las Radeon RX 6000 y la caché infinita, pero esto no es del todo correcto, ya que estamos hablando de caché de segundo nivel, y no de caché de tercer nivel, como la que utilizó AMD. Si no tienes claro qué diferencia hay entre ambas, echa un vistazo a este especial que publicamos en su momento sobre la caché y sus diferentes niveles. En cualquier caso, lo importante es tener claro que ese aumento de caché podría mejorar bastante el rendimiento en términos brutos.

NVIDIA AD102

Empezamos con el núcleo gráfico más potente de todos los que se han filtrado. Este chip tendría una configuración de 144 unidades SM (Stream Multiprocessor). Si NVIDIA mantiene la configuración actual de 128 shaders por cada unidad SM, esta GPU tendría un total de 18.432 shaders.

Se espera que, en las soluciones gráficas más potentes dentro de la serie RTX 40, esta GPU venga acompañada de un bus de memoria de 384 bits, y que cuente con hasta 96 MB de caché L2. El resto de sus especificaciones no han trascendido, pero si NVIDIA mantiene la estructura que hemos visto en Ampere el chip AD102 debería contar con 576 unidades de texturizado, 576 núcleos tensor y 144 núcleos RT.

Los modelos que podrían utilizar este núcleo gráfico son las GeForce RTX 4090, GeForce RTX 4080 Ti y GeForce RTX 4080.

NVIDIA AD103

Este es uno de los núcleos gráficos que creo que podría ser exclusivo para el sector portátil, y no hablo sin motivo, ya que el GA103 fue utilizado en las RTX 3080 Ti Mobile y RTX 3070 Ti Mobile, aunque es cierto que algunas unidades con menos shaders activos se han utilizado ocasionalmente en unidades de la GeForce RTX 3060 Ti, pero solo en el mercado chino, que yo sepa.

El núcleo gráfico AD103 tendrá 84 unidades SM, lo que implica que podría contar con hasta 10.752 shaders, y tendría 64 MB de caché L2. El bus de memoria que utilizará NVIDIA será de 256 bits, y si se mantiene la división actual de 4 TMUs y un núcleo RT por unidad SM, este chip tendría 336 unidades de texturizado, 336 núcleos tensor y 84 núcleos para trazado de rayos.

Los modelos que utilizarán este chip serán, como adelantamos, soluciones gráficas de alto rendimiento para portátiles, probablemente las GeForce RTX 4080 Ti Mobile y GeForce RTX 4080, entre otras.

NVIDIA AD104

Saltamos ahora a ver una GPU de gama media-alta que será una de las grandes estrellas dentro de las GeForce RTX serie 40. Este chip contará con 60 unidades SM, lo que vienen a ser un total de 7.680 shaders, y tendrá 48 MB de caché L2. Como podemos apreciar, se produce un recorte importante de especificaciones, y lo mismo aplica al bus de memoria, que sería de 192 bits.

Manteniendo el enfoque a nivel de arquitectura que venimos viendo, esta GPU debería contar con 240 unidades de texturizado, 240 núcleos tensor y 60 núcleos para trazado de rayos.

Este núcleo gráfico podría tener cabida en las GeForce RTX 4070, GeForce RTX 4060 Ti y GeForce RTX 4060. Estoy seguro de que ahora entendéis por qué dije que iba a ser una de las grandes estrellas dentro las nuevas tarjetas gráficas GeForce RTX serie 40.

NVIDIA AD106

Nos encontramos ahora ante un chip de gama media económica que sumaría 36 unidades SM, lo que nos dejaría un conteo de 4.608 shaders. La memoria caché L2 bajaría a los 32 MB, y lo mismo ocurre con el bus de memoria, que sería de 128 bits.

Partiendo de la misma división de 4 TMUs y un núcleo RT por unidad SM que venimos aplicando, podemos concluir que la GPU AD106 tendría un máximo de 144 unidades de texturizado, 144 núcleos tensor y 36 núcleos RT.

Esta GPU se utilizará en las GeForce RTX 4050 y GeForce RTX 4050 Ti.

NVIDIA AD107

Este sería el segundo chip exclusivo para el sector portátil y tenemos, de nuevo, un precedente claro en el actual GA107, que fue utilizado en las GeForce RTX 3050 y 3050 Ti Mobile. Estará equipado con 24 unidades SM y 3.072 shaders. Mantendrá los 32 MB de caché L2 que vimos en el AD106, y tendrá un bus de 128 bits.

El resto de sus especificaciones se completarían con 96 unidades de texturizado, 96 núcleos tensor y 24 núcleos RT.

Esta GPU debería limitarse, en teoría, a las GeForce RTX 4050 Mobile y GeForce RTX 4050 Ti Mobile.

Las GeForce RTX serie 40 utilizarán núcleos RT de tercera generación y núcleos tensor de cuarta generación

Con el lanzamiento de las GeForce RTX serie 30, NVIDIA introdujo cambios muy profundos a nivel de arquitectura que ya os contamos en su momento en este artículo, donde repasamos sus diez claves más importantes. Una de esas claves fue que dicha arquitectura logró doblar los motores de sombreado, pero no debemos olvidarnos también de que supuso la introducción de los núcleos RT de segunda generación y de los núcleos tensor de tercera generación.

No esperamos que el conteo de shaders por unidad SM cambie con Ada Lovelace, y tampoco la estructura base de 4 TMUs, 4 núcleos tensor y un núcleo RT por unidad SM, pero sí que estoy seguro de que NVIDIA introducirá, con dicha arquitectura, núcleos RT de tercera generación y núcleos tensor de cuarta generación. ¿Qué supondrá esto para el usuario? Vamos a verlo con detalle.

Los núcleos tensor se introdujeron con la arquitectura Volta, aunque en principio fue una exclusiva de las soluciones gráficas profesionales de NVIDIA ya que, al final, esos núcleos aceleraban cargas de trabajo basadas en IA, inferencia y aprendizaje profundo. No tenían valor aplicados al gaming ya que, en aquel momento, no existía la tecnología DLSS.

Turing, la arquitectura que sucedió a Volta, fue la elegida por NVIDIA para introducir los núcleos tensor en el mercado de consumo general. A nosotros llegó la segunda generación de estos, y estuvo acompañada del DLSS, una tecnología que tuvo un debut cuestionable y criticado, pero que al final ha demostrado que representa un valor fantástico, y que no tiene rival a día de hoy.

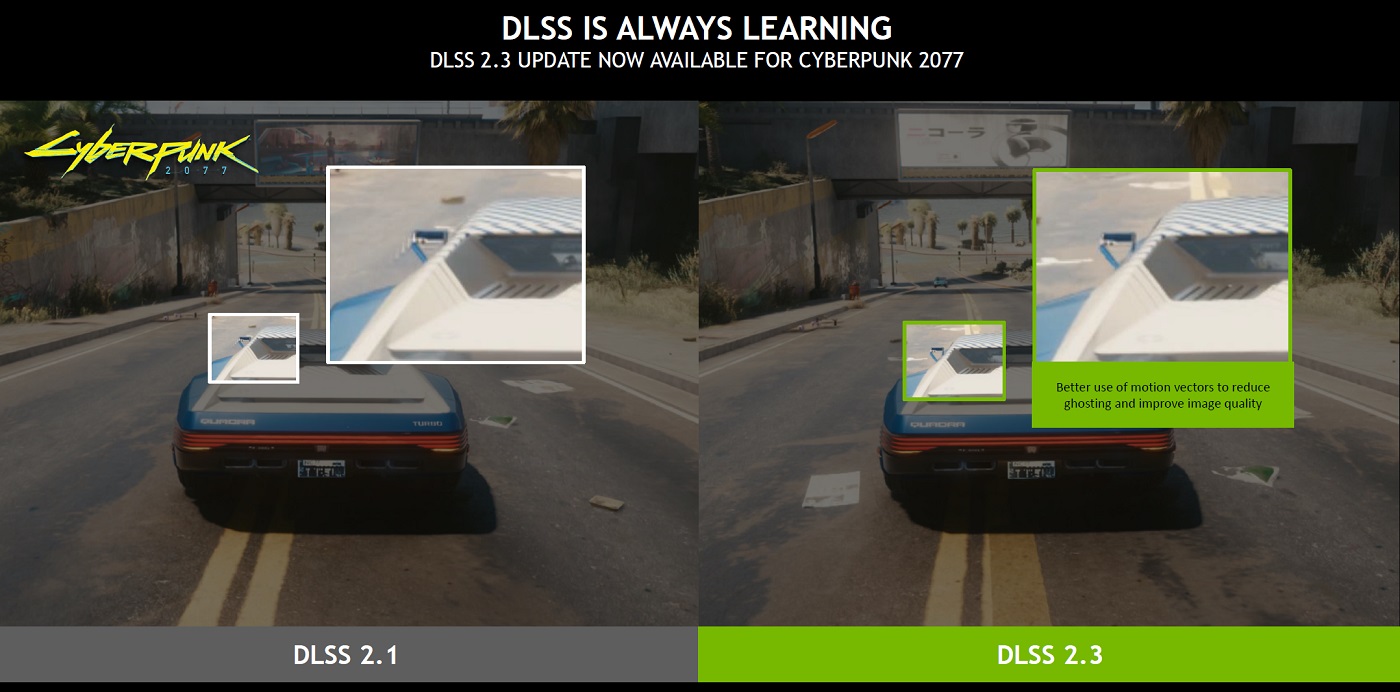

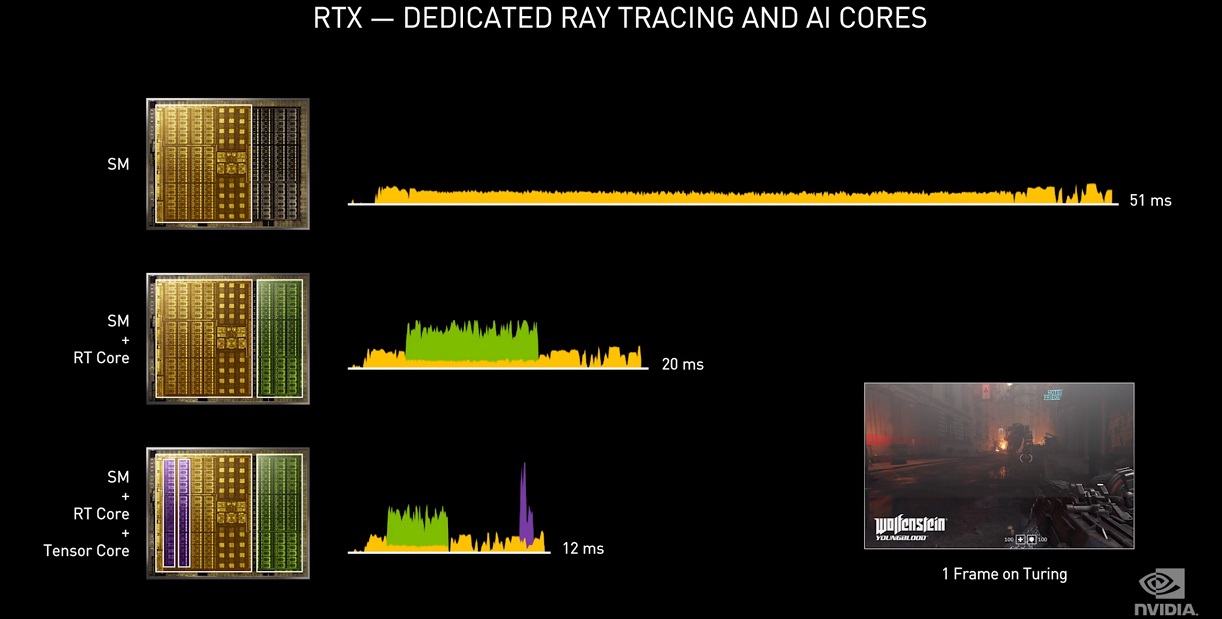

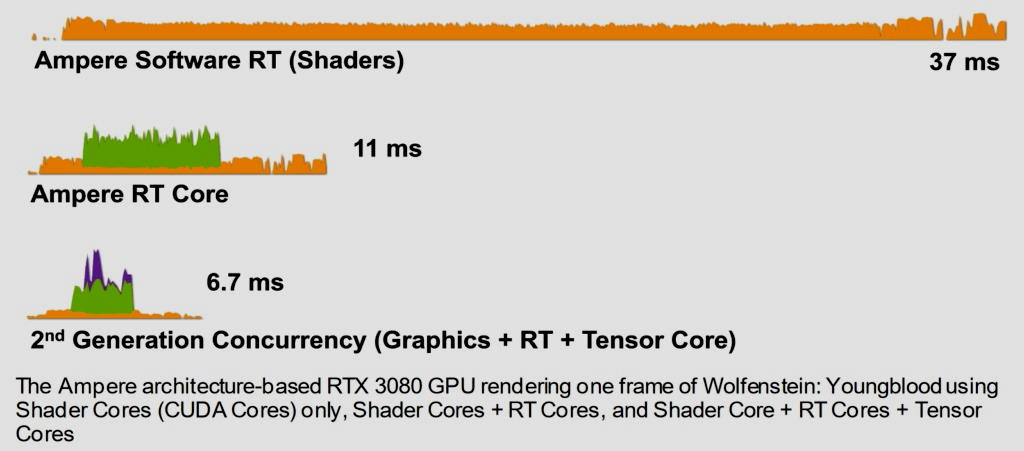

Un DLSS más avanzado, y con un mayor rendimiento

Los núcleos tensor se encargan de sacar adelante toda la carga de trabajo que representa el algoritmo utilizado por la tecnología DLSS. Esto quiere decir que la GPU tiene que asumir una carga para poder aplicar el DLSS, es decir, no es algo que no tenga un coste determinado en términos de rendimiento. Sin embargo, al realizarse toda esa carga que representa sobre hardware altamente especializado, su impacto es menor comparado con el que tendría el sistema trabajando con resolución nativa. Obviamente, cuantos más núcleos tensor tengamos, o cuanto más potentes sean estos, menor será el impacto del DLSS y mayor será la mejora de rendimiento que supondrá.

Vamos a entenderlo mejor con un ejemplo. Imagina que tenemos una tasa de 30 FPS con un juego en 4K nativo. Cada fotograma se renderiza en un tiempo de 33,33 milisegundos. Si aplicamos el DLSS, la utilización de esta tecnología tendría un impacto determinado de unos pocos milisegundos en la generación de cada fotograma, pero al reducir la carga de píxeles con la que estos se renderizan compensaría, de sobra, no solo su consumo propio de recursos, sino que además mejoraría sustancialmente el rendimiento.

Siguiendo con el ejemplo anterior, ya vimos en nuestro análisis de la GeForce RTX 3050 que Cyberpunk 2077 funcionaba a 24 FPS con trazado de rayos y resolución 1080p, pero que al activar el DLSS en modo calidad el rendimiento sube a 43 FPS. En el primer caso, el tiempo de renderizado de cada fotograma es de 41,66 milisegundos, y en el segundo se ha reducido, gracias al DLSS, a 23,25 milisegundos.

Gracias a la utilización de núcleos tensor de cuarta generación, podemos esperar dos grandes avances: un mayor rendimiento al activar el DLSS, incluso con una cantidad menor de núcleos tensor, como ya ocurrió cuando se produjo la llegada de las GeForce RTX serie 30, y la implementación de un DLSS más avanzado. En este sentido, hay que recordar lo que representó el DLSS de segunda generación frente al de primera generación, el salto fue enorme, y desde entonces esta tecnología no ha dejado de mejorar. Puede que, con la llegada de las GeForce RTX serie 40, se produzca en algún momento el lanzamiento del DLSS de tercera generación.

Núcleos RT más avanzados, ¿qué podemos esperar?

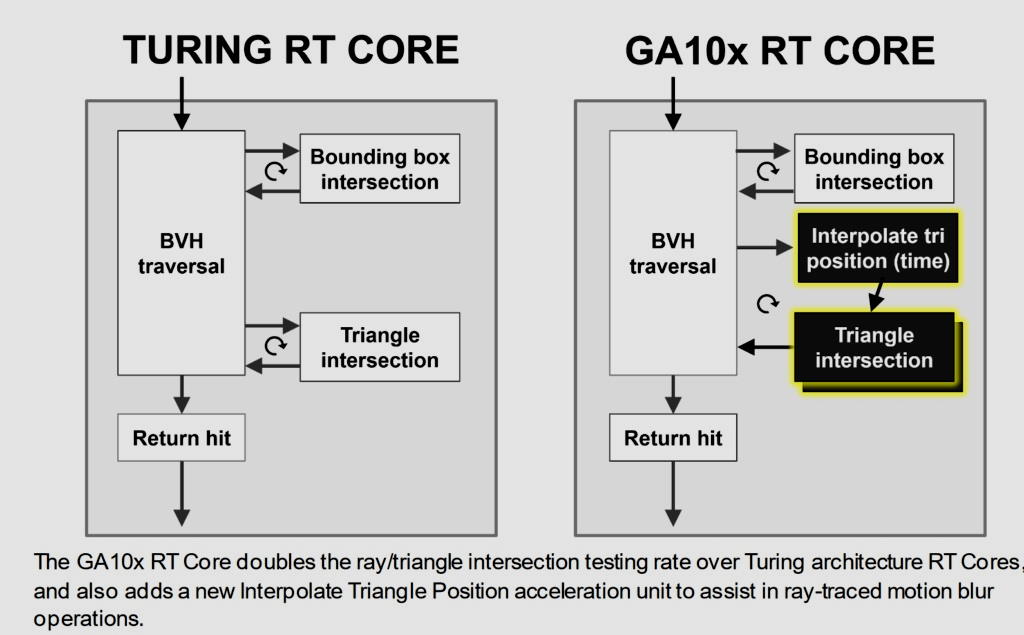

Los núcleos RT de segunda generación doblaron la capacidad de cálculo de intersecciones rayo-triángulo, y siguieron ocupándose del trabajo que representaban tanto estas como de las intersecciones transversales BVH, las intersecciones delimitadoras de cuadro y el sistema de colisiones. También se introdujo la interpolación de cada triángulo en el tiempo para poder aplicar desenfoque de movimiento, y la capacidad de trabajar de forma totalmente asíncrona, sin tener que esperar a los shaders.

En la práctica, la mejora que representó el uso de núcleos RT de segunda generación fue tan grande que, por ejemplo, una RTX 3060 Ti pudo superar sin problemas a la RTX 2080 Super en trazado de rayos, incluso a pesar de que la primera solo tiene 38 núcleos RT, mientras que la segunda tiene 48 núcleos RT (de primera generación). Lo mismo ocurre con la RTX 3060, que supera a la RTX 2070 en trazado de rayos a pesar de que la primera tiene 28 núcleos RT y la segunda 36 núcleos RT.

Por otro lado, no debemos olvidarnos de que la aplicación del trazado de rayos se ha vuelto cada vez más compleja, y esto se ha traducido en una mayor calidad gráfica. Hemos pasado de una aplicación mínima, limitada solo a sombras y reflejos, y ocasionalmente a su vertiente más exigente, la iluminación global, a encontrarnos con juegos que utilizan esta tecnología en todos esos frentes. Cyberpunk 2077, Metro Exodus Enhanced Edition y Dying Light 2 son, sin duda, los mejores exponentes. Obviamente, esto no habría sido posible sin los núcleos RT.

He querido hacer esas comparaciones para que tengáis el contexto necesario para entender qué es lo que podemos esperar de los núcleos RT de tercera generación, y de su integración en las GeForce RTX serie 40. Como habréis podido imaginar, cabe esperar una mejora notable de rendimiento frente a los núcleos RT de segunda generación, lo que debería traducirse en un menor impacto del trazado de rayos en juegos y en una mayor tasa de FPS, pero también puede que esto abra las puertas a un trazado de rayos todavía más complejo y más rico en juegos.

No quiero adelantarme ni pecar de optimista, pero viendo la diferencia que marcó el hardware especializado a la hora de permitir la llegada del trazado de rayos al mundo del gaming, y cómo ha evolucionado esta tecnología en los últimos dos años, creo que tenemos razones de sobra para ser positivos, aunque sin despegar los pies del suelo.

¿Qué rendimiento podemos esperar de las GeForce RTX serie 40?

No voy a entrar a valorar esta cuestión desde la perspectiva de los TERAFLOPs ya que, al final, esta medida no determina el rendimiento real que podemos esperar en juegos. Con todo, por si alguien tiene alguna duda voy a poneros un ejemplo sencillo y fácil de entender.

La GeForce RTX 2080 Ti ofrecía una potencia en FP32 de 16,1 TFLOPs, mientras que la RTX 3090 alcanza los 35,58 TFLOPs. Como podemos apreciar, la segunda supera en más del doble a la primera. Sin embargo, en juegos la segunda rinde, de media, un 36% más en juegos bajo resolución 4K. Como podemos apreciar, el valor de los TFLOPs es muy distinto al valor de rendimiento real en juegos.

Partiendo de todo lo que hemos visto hasta ahora, y viendo lo que ocurrió con las GeForce RTX serie 30, creo que la mejora que van a marcar las GeForce RTX serie 40 va a ser muy grande en términos de potencia computacional, y también muy marcada en juegos, sobre todo si se confirma ese aumento de la memoria caché L2.

Por otro lado, no debemos olvidarnos de que el uso de núcleos tensor de cuarta generación debería abrir las puertas a un DLSS más avanzado, mientras que los núcleos RT de tercera generación marcarán otro paso hacia delante en el complicado camino que nos llevará a terminar de «domar» el trazado de rayos, es decir, debería mejorar el rendimiento y permitir una aplicación más amplia y compleja de dicha tecnología.

Sé que estáis deseando ver una relación de equivalencias aproximadas para tener más claro cómo mejorarán el rendimiento las GeForce RTX serie 40 frente a las GeForce RTX serie 30, y no os voy a dejar con las ganas. Estos son los niveles de rendimiento aproximados, centrados en juegos, que creo que ofrecerán las nuevas GeForce RTX serie 40:

- GeForce RTX 4090: debería superar a la GeForce RTX 3090 por un 50%, aproximadamente. Podría costar entre 1.599 y 1.799 dólares.

- GeForce RTX 4080: su rendimiento debería ser ligeramente superior al de la GeForce RTX 3090, probablemente un 15% más potente. Este modelo debería costar entre 799 y 899 dólares.

- GeForce RTX 4070: este modelo quedará casi al mismo nivel de rendimiento que la GeForce RTX 3090. Su precio podría rondar entre los 599 y los 699 dólares.

- GeForce RTX 4060 Ti: debería ser similar a una GeForce RTX 3080 de 12 GB. Es probable que cueste entre los 449 y los 499 dólares.

- GeForce RTX 4060: este modelo estará al nivel de una GeForce RTX 3070 Ti, puede que ligeramente por debajo de aquella hasta que madure a nivel de drivers. El precio de este modelo debería situarse entre los 329 y los 399 dólares.

- GeForce RTX 4050: lo más probable es que se sitúe al nivel de una GeForce RTX 3060. Debería costar entre 229 y 299 dólares.

Tened en cuenta que mis estimaciones son bastante conservadoras, ya que quiero evitar un «hype» innecesario, y tengo motivos para ello, puesto que en el pasado también se llegó a decir que Ampere iba a doblar el rendimiento de Turing y al final esto solo se cumplió en términos de capacidad de cálculo de operaciones de coma flotante, pero no en juegos.

¿Debería esperar a las GeForce RTX serie 40 o comprar una GeForce RTX serie 30 cuando pueda?

La verdad es que es una pregunta muy complicada, y con el panorama actual me resulta dar una respuesta con total confianza. Muchos me dirán que lo mejor es esperar, y que comprar ahora una GeForce RTX serie 30 es una mala idea, pero creo que no están teniendo en cuenta dos claves importantísimas.

La primera es que no conocemos la disponibilidad real que van a tener las GeForce RTX serie 40 ni la demanda que van a tener que afrontar. Estas podrían verse afectadas por la escasez de chips, que todavía sigue vigente, y también por los problemas que aún azotan a la cadena de suministros y por la especulación y reventa. Con esto quiero decir que quizá no puedas comprar una GeForce RTX serie 40 en su lanzamiento, ni en las semanas o meses posteriores, porque podrían agotarse de forma inmediata.

Si esperas a comprar una GeForce RTX serie 40, puede que al final acabes esperando aún más, y precisamente de todo lo que acabamos de decir viene la segunda clave, que no conocemos todavía los precios de venta ni sabemos si estos podrían verse inflados por una nueva escasez, y por la concurrencia de la especulación y la reventa. Siguiendo con el ejemplo anterior, puede que acabes en una encrucijada en la que ya no puedas comprar una GeForce RTX serie 30 nueva por haber esperado demasiado, y que tampoco puedas hacerte con una GeForce RTX serie 40 a un precio aceptable.

Personalmente, estoy convencido de que la demanda de tarjetas gráficas GeForce RTX serie 40 va a ser muy alta, y de que la especulación y la reventa va a seguir haciendo daño, así que si necesitas una tarjeta gráfica y tienes la suerte de encontrar una GeForce RTX serie 30 a buen precio no te lo pienses mucho, ya que todavía hay muchos interrogantes en el aire, y podrías acabar cometiendo un importante error.

-

GuíasHace 6 días

GuíasHace 6 díasQué placa base elegir: Guía de compras para Intel y AMD

-

GuíasHace 2 días

GuíasHace 2 díasGuía para diferenciar generaciones y gamas de tarjetas gráficas

-

A FondoHace 6 días

A FondoHace 6 díasOfertas Flash del Black Friday 2024 de PcComponentes

-

A FondoHace 4 días

A FondoHace 4 díasGeForce RTX 5050, especificaciones, rendimiento, equivalencias, fecha de lanzamiento y posible precio